0 引言

目前, 针对多源图像融合的研究已经取得了很多成果。多尺度几何变换的图像融合方法得到了广泛的应用[5-6]。具有多分辨率特征的小波变换可以较好地反映图像的局部变化特征[7-9], 但并不适用于处理具有各向异性的奇异性特征图像, 且不具备移位不变性, 易导致融合图像的边缘或纹理信息不连续。因此, 文献[10]提出非下采样轮廓变换(non-subsampled contourlet transform, NSCT)方法, 该方法不仅继承了之前算法的优点, 同时还具有平移不变性, 将其应用到红外与可见光图像的融合中, 既突出了图像中的热目标, 又可以丰富纹理信息, 但融合后图像仍存在边缘模糊及纹理不清晰的问题。为解决上述问题, 文献[11]应用NSCT结合脉冲耦合神经网络(pulsecoupled neural network, PCNN)的图像融合方法进行研究, 使融合效果取得了一定程度的改善, 但NSCT算法计算量大, 运行速度慢。

为了解决NSCT计算复杂度高的缺点, 文献[12]应用非下采样剪切波变换(non-subsampled shearlet transform, NSST)代替NSCT对源图像进行分解。NSST不仅具备了NSCT的所有优点, 同时算法更加简单、计算耗时更短, 因此在多源图像融合方法中得到了广泛的应用。文献[13-15]对融合规则进行改进, 融合效果被进一步改善, 但仍存在边缘模糊、纹理信息丢失的问题。文献[16]提出了应用NSST与导向滤波相结合的图像融合方法, 去除了源图像上的部分噪声, 增强了图像边缘细节信息, 融合效果较好, 但该方法在对清晰度差的图像进行融合时, 会导致大量的细节信息丢失, 融合效果不佳。

以上各种融合算法虽然在融合效果及融合速度上取得了一定的成果, 但并没有考虑到源图像的自身特征, 未能充分利用源图像的目标及场景信息, 导致融合图像易受噪声影响, 且存在对比度差、清晰度不佳等问题。针对上述问题, 本文提出了一种针对红外与低照度图像特征的融合算法。首先, 通过红外与低照度图像的三维分布图、直方图, 对比分析其图像表现出的特征信息, 根据其特征信息对图像进行处理。为了凸显红外图像目标信息, 采用各向异性导向滤波对其进行去噪、平滑处理。为了增强低照度图像场景细节信息, 采用改进的广义全变分去噪算法结合巴特沃斯高通滤波,对其进行去噪、增强处理。在此基础上, 采用NSST对红外图像与低照度图像进行分解, 分别得到低频子带图像和高频子带图像。在融合规则上, 为了保留低频子带图像中的高频信息, 采用改进的拉普拉斯加权算法结合图像区域能量来融合低频系数。为了获得图像多个方向的梯度能量, 采用改进的空间频率作为PCNN神经元的外部激励融合高频系数。最后, 利用非下采样剪切波逆变换得到融合后的图像。

1 红外图像与低照度图像的特征分析

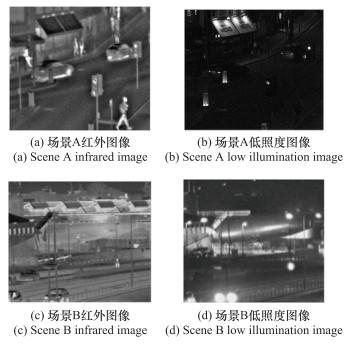

红外传感器通过探测物体发出的红外辐射, 将人眼不可见的辐射信息转换为人眼可见、清晰的红外图像。红外图像中目标(行人、车辆等)与背景(树木、道路等)的辐射亮度差异较大, 利于目标的识别, 但红外图像缺少细节信息, 无法对目标所处的环境以及目标本身的细节进行进一步的识别。低照度图像是指在光照不佳的环境或夜晚拍摄的图像, 相对于红外图像, 可以较为清晰地反映图像中场景的细节信息, 但目标特征不突出, 易被背景掩盖。

图1

图2

图2

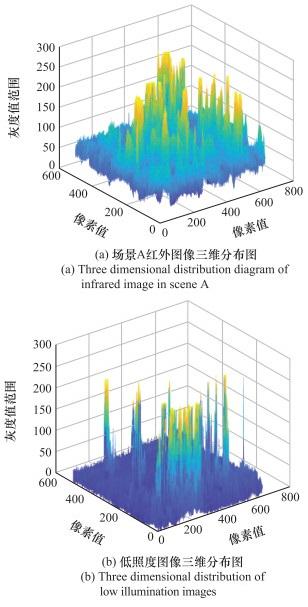

红外与低照度图像三维分布图

Fig.2

Three-dimensional distribution diagram of infrared and low illumination images

由图 2(a)可以看出:

(1) 噪声(图中较小波动部分)对与环境温差较小的目标(较高凸起部分)影响较大;

(2) 像素值集中在50~250之间, 说明相对于低照度图像, 红外图像亮度较高, 因此若对红外图像进行去噪、平滑处理,可以有效提升融合图像的亮度与清晰度。

由图 2(b)可以看出:

(1) 图中较高凸起对应图像中路灯、车灯等被灯光照亮的部分;

(2) 像素多集中在0~50的范围, 说明低照度图像亮度差、清晰度不佳, 相比于红外图像而言无法区分目标与背景;

(3) 图中的较小波动说明低照度图像也受到了噪声的影响, 由于低照度图像中目标、背景、噪声反映在三维分布图中没有明显的区分, 因此在对低照度图像去噪的同时还需保留和增强图像中的边缘细节。

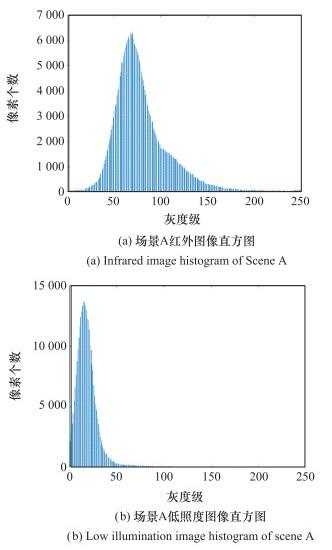

从直方图可以直观地看出图像对比度的大小, 图 3分别给出场景A红外图像和低照度图像的直方图。

图3

从图 3可以看出, 红外图像的灰度值范围相较于低照度图像灰度值范围更大。此外, 红外图像会出现表示目标和背景的两个峰值, 而低照度图像往往只存在一个较为明显的峰值。在图像融合中, 需要红外图像来反映目标, 低照度图像反映场景细节, 因此, 需要提高低照度图像的动态范围, 增加对比度。

2 基于图像特征的红外图像与低照度图像融合算法

2.1 融合算法原理

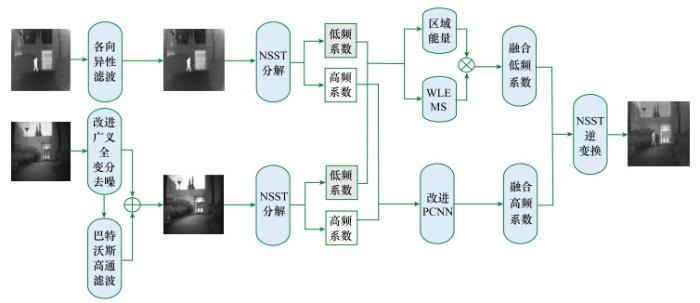

本文首先通过红外与低照度图像的三维分布图、直方图对比分析图像表现出的特征信息, 根据其特征信息对图像进行处理。为了凸显红外图像目标信息、提高红外图像清晰度, 消除噪声、虚影等干扰成分, 需要采用各向异性导向滤波对其进行去噪、平滑处理。为了增强低照度图像场景细节信息, 消除噪声, 采用改进的广义全变分去噪算法结合巴特沃斯高通滤波对其进行去噪、增强处理。在此基础上, 采用NSST对红外图像与低照度图像进行分解, 分别得到低频子带图像和高频子带图像。在融合规则下, 为了保留低频子带图像中的高频成分, 采用改进的拉普拉斯加权算法结合图像区域能量来融合低频系数。为了保留高频子带中的细节分量, 采用改进的空间频率作为PCNN神经元的外部激励融合高频系数, 算法原理图如图 4所示。

图4

图4

基于图像特征的红外图像与低照度图像融合算法原理图

Fig.4

Principle schematic diagram of infrared image and low illumination image fusion algorithm based on image features

2.2 图像预处理

2.2.1 红外图像预处理

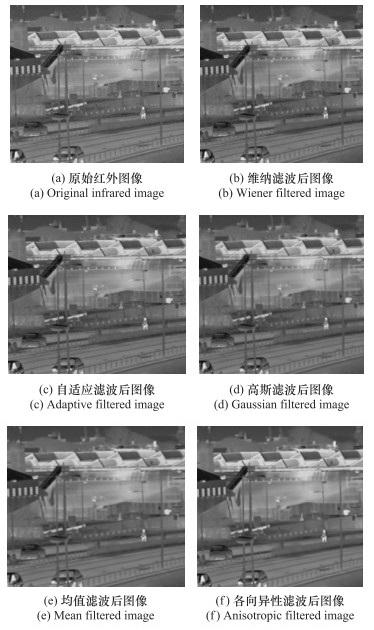

受环境、红外传感器自身缺陷以及信号处理方式的影响, 红外图像中存在多种噪声。目前, 维纳滤波、自适应中值滤波、高斯滤波、均值滤波等方法常被用于图像去噪, 但以上方法大多假设图像中的噪声为高斯噪声, 对红外图像中实际噪声的处理效果并不理想。文献[17]应用各向异性导向滤波方法用于红外图像与可见光图像的融合过程, 但由于其只针对权重图进行去噪处理, 仍有部分噪声对融合图像产生影响。为了给更多红外图像中的目标信息去除干扰, 本文对源图像应用各向异性导向滤波进行去噪、平滑处理。

给定一幅含有噪声的图像I(x, y), 应用各向异性导向滤波对图像的处理过程为

4个散度在4个方向上对当前像素求偏导为

4个方向上的导热系数为

式中:▽N(I(x, y))、▽S(I(x, y))、▽E(I(x, y))、▽W(I(x, y))分别表示4个散度在4个方向上对当前像素(x, y)求偏导;cNx, y、cSx, y、cEx, y、cWx, y分别表示4个方向上的导热系数;t为迭代次数; k表示导热系数; λ为控制平滑程度, 通常取接近0的较小整数。

图5

2.2.2 低照度图像预处理

通过前文对低照度图像的三维分布图、直方图分析可知, 低照度图像存在对比度低、噪声强等问题。为了得到更好的融合结果, 需要对低照度图像进行去噪、增强处理。目前自适应直方图均衡化、灰度变换、基于Retinex的图像增强算法等方法常被用于图像增强处理, 这些方法在白天拍摄的图像处理上具有较好的效果, 但在应用于夜晚拍摄的图像时处理效果不佳。文献[18]提出广义全变分去噪算法, 该算法既可保留图像低频信息, 又可增强图像高频信息, 但其对图像边缘细节的增强效果不佳。因此, 提出改进广义全变分去噪算法结合巴特沃斯高通滤波, 进一步增强图像的边缘细节信息。

假设g(x, y)为无噪声图像, z(x, y)为含噪声图像, μ(x, y)为零均值, 随机噪声信号方差为δ2, 则有

利用广义全变分去噪模型可以将图像去噪看作最小化问题:

式中:

其导出的欧拉—拉格朗日方程为

改进的巴特沃斯高通滤波的传递函数为

式中: D0表示截止频率; Rh、Rl分别表示高频增益与低频增益, 且Rh>1、Rl<1;C为常数;D(u, v)是从点(u, v)到频率平面原点的距离,D(u, v)=(u2+v2)1/2。

设f1(x, y)为经广义全变分算法去噪后的图像, f2(x, y)为经改进的巴特沃斯高通滤波器去噪后的图像, f(x, y)为两种方法结合去噪后的图像。3种图像的关系如下:

式中: k为比例系数, 且k>1。

经过去噪后的低照度图像再由巴特沃斯高通滤波器提取其高频分量, 其传递函数为

式中: D1为截止频率; n为阶数。

图6

2.3 红外图像与低照度图像融合

2.3.1 NSST方法

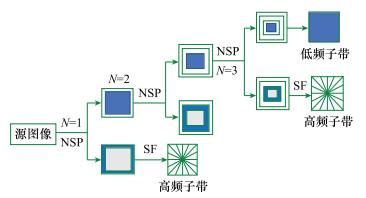

NSST方法是由Easley等[19]提出的一种结合几何与多尺度分析的方法, 其变换过程主要分为两步: 多尺度分解与方向局部化。多尺度分解由非下采样金字塔(non-subsampled pyramid, NSP)实现, 保证平移不变性, 从而抑制伪吉布斯现象; 方向局部化由剪切波滤波器(shearlet filter, SF)实现。

源图像首先经NSP分解为1个低频子带图像和k个大小相同但尺度不同的高频子带图像。高频子带图像再经SF进行l级多方向分解, 形成2l个高频方向子带, 其过程如图 7所示。

图7

2.3.2 PCNN方法

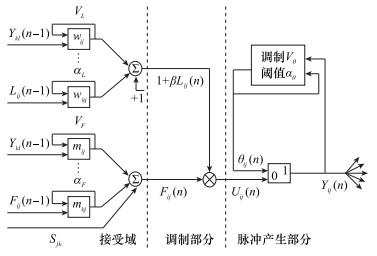

图8

PCNN的每一个神经元由三部分组成: 接受域、调制部分、脉冲产生部分。

接受域负责接收外部输入, 然后经由L通道和F通道输出信号。调制部分由L通道输出信号Ljk叠加一个正偏移量后与F通道输出信号Fjk相乘调制。脉冲产生部分由阈值比较器和脉冲产生器组成, 当阈值θjk超过阈值Ujk时, 脉冲产生器将停止发送脉冲; 反之, 则神经元点火, 输出脉冲。

脉冲神经网络的工作过程为: 如果神经元有脉冲输出, 动态门限会突然增大, 当增大到不能产生脉冲输出时, 动态门限会呈指数衰减。当动态门限衰减到小于内部活动项时, 脉冲又再次产生, 周而复始。脉冲的输入输出状态影响神经元的激发状态, 神经元之间通过m和w进行信息互连。脉冲神经网络运行时, 神经元之间按照如下计算过程循环计算。

(1) 通过两个通道接收的输入信号、上一时刻的点火矩阵、连接系数等计算Fij(n)及Lij(n):

(2) 两个通道的结果被送到调制部分, 加权相乘调制得到状态信号Uij(n):

(3) 在脉冲产生部分,将Uij(n)与动态阈值θij(n)进行比较。当Uij(n)大于θij(n)时,脉冲产生器打开,神经元点火输出脉冲;当Uij(n)小于θij(n)时,脉冲产生器关闭。输出脉冲为

(4) 神经元点火时, 阈值迅速升高, 然后衰减至再次点火, θij(n)为

式中:i, j, k, l为下标号;Sij表示外部刺激;mijkl、wijkl表示链接权矩阵;αF、αL、αθ表示衰减系数;VF、VL、Vθ表示幅度常数;β表示链接强度;n表示迭代次数。

2.3.3 融合算法

(1) 低频融合规则

定义八邻域改进拉普拉斯加权和(weighted sum of eight-neighbor modified Laplacian, WSEML), 结合区域能量E来选择低频系数, 其公式如下:

式中: p∈{V, L}, V和L分别为红外图像与低照度图像, 其区域大小为(2r+1)·(2r+1);DLp(i, j)为低频系数; w(m+r+1, n+r+1)为各点权重;EMLp(i, j)表示改进的拉普拉斯加权算法。

(2) 高频融合规则

高频子带会带有图像中重要的轮廓边缘信息, 为了更好地保留高频子带中的细节分量, 如边缘、直线、边界信息等, 应用改进的空间频率作为PCNN神经元的外部激励融合高频系数。传统的空间频率只能计算一个方向的梯度能量, 为了获得图像多个方向的梯度能量, 特采用改进空间频率作为PCNN神经元的外部激励, 对于大小为M×N的图像, 改进的空间频率MSF为

式中: RF、CF分别表示行频率和列频率; MDF、SDF分别表示主对角频率和副对角频率。

(3) 融合流程

针对红外图像与低照度图像特点, 基于图像特征、NSST、区域能量、PCNN等进行融合规则的制定, 可以有效保留融合图像边缘轮廓等细节信息, 提高融合图像清晰度。

具体步骤如下。

步骤1 用各向异性导向滤波对红外图像进行滤波。

步骤2 利用改进的广义全变分去噪算法结合巴特沃斯高通滤波对低照度图像进行去噪和细节增强。

步骤3 对预处理后的红外图像和低照度图像分别进行NSST分解, 获得高频子带图像和低频子带图像。

步骤4 对于低频子带图像, 遍历每个像素点, 选取区域能量E和WSEML乘积的较大值作为低频融合系数。

步骤5 利用PCNN准则选择高频系数, 其过程如下。

① 令Fij(0)=0、Lij(0)=0、Uij(0)=0、θij(0)=0、Yij(0)=0。

② 利用MSF值激励PCNN。

③ 通过式(10)~式(14)计算Lij(n)、Uij(n)、θij(n)。

④ 重复以上步骤, 直至n=N时停止迭代, 选取较大点火次数的子带系数作为高频融合系数。

步骤6 对处理后的低频分量及高频分量进行NSST逆变换,得到最终融合图像。

3 实验结果及分析

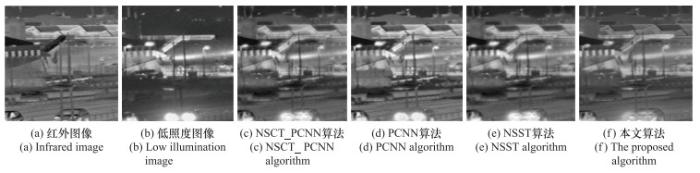

为了测试所提算法的有效性,从由加拿大光学研究所发布的公开数据集(简称为INO)[23]和由荷兰组织应用科学研究院发布的公开数据集(简称为TNO)[24]中选取配准的红外图像与低照度图像进行实验。实验环境为: Matlab R2018b, 64位Windows10操作系统, 8 GB内存, Intel(R) Core(TM) i7-7500U CPU @2.70 Hz 2.9 GHz处理器。实验参数首先分别根据文献[20]、文献[21]、文献[25]、文献[26]初步确定, 然后根据红外图像与低照度图像特点及应用算法原理对参数进行调整, 并进行大量实验。最后选择的最优参数组为: 各向异性导向滤波算法中t=20、k=5、λ=0.15;改进广义全变分去噪算法中λ=0.5、p=0.5、D0=18、Rh=1.7、Rl=0.8、C=0.6、K=1.2、D1=0.1、n=15;多尺度分解选取“maxflat”滤波器, 分解层数为4, 方向数为{3, 3, 4, 4};PCNN模型中N=200, aL=0.069 31, aθ=0.2, VL=1.0, Vθ=20, β=5。采用3种算法与本文算法进行比较, 分别为NSCT_PCNN[25]算法、PCNN[26]算法、NSST[27]算法。

3.1 主观视觉评估

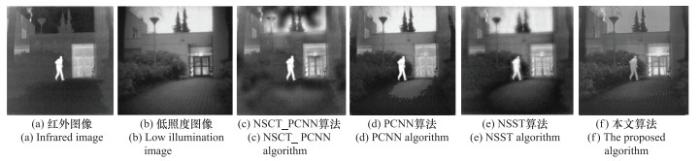

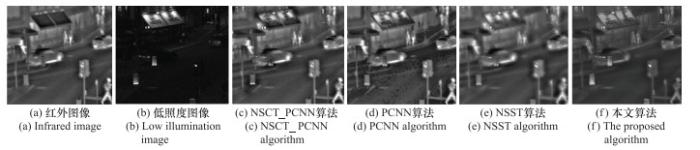

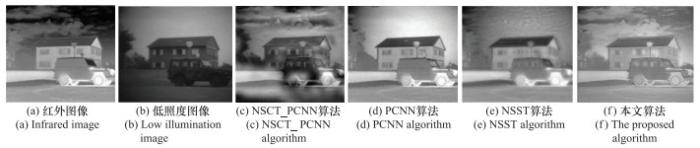

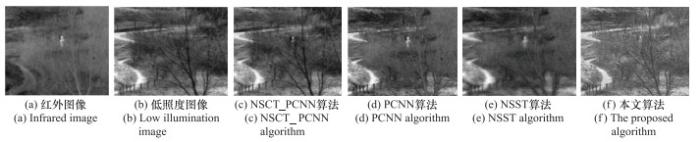

本节给出了各种方法对不同场景下的5幅图像(夜间复杂马路、凌晨走廊、夜间繁华街道、凌晨郊区、凌晨山区)的融合结果。夜间复杂马路图像见图 9。

图9

图10

图11

图12

图13

由图 13可以看出, 对于凌晨山区图像, NSCT_PCNN算法的融合图像效果较好, 不足的是亮度和清晰度表现不佳; PCNN算法的融合图像场景细节较为模糊, 红外目标过亮; NSST算法的融合图像场景细节信息严重缺失, 存在光晕伪影; 本文算法的融合图像亮度和清晰度均表现较好, 场景的细节信息清晰可见。

3.2 客观评价结果

表1 5组不同场景下的融合图像客观评价指标

Table 1

| 源图像 | 指标 | NSCT_PCNN | PCNN | NSST | 本文算法 |

| 第1组 | IE | 6.561 8 | 6.668 0 | 6.569 1 | 7.791 8 |

| SD | 45.329 1 | 45.423 4 | 45.356 8 | 60.576 2 | |

| AG | 7.453 2 | 7.612 8 | 7.642 0 | 8.921 0 | |

| QAB/F | 0.504 0 | 0.564 1 | 0.521 0 | 0.582 8 | |

| 第2组 | IE | 6.803 2 | 5.521 9 | 6.674 2 | 7.313 0 |

| SD | 38.751 7 | 38.721 0 | 38.854 2 | 74.012 5 | |

| AG | 5.781 6 | 5.359 6 | 5.742 9 | 8.672 0 | |

| QAB/F | 0.340 2 | 0.561 6 | 0.551 3 | 0.584 2 | |

| 第3组 | IE | 6.541 2 | 6.211 2 | 6.421 3 | 7.294 6 |

| SD | 26.324 0 | 24.104 2 | 26.214 0 | 50.321 1 | |

| AG | 4.401 5 | 3.014 2 | 4.025 6 | 6.121 0 | |

| QAB/F | 0.391 8 | 0.401 2 | 0.354 2 | 0.471 3 | |

| 第4组 | IE | 6.701 2 | 7.399 5 | 7.066 8 | 7.651 6 |

| SD | 23.191 2 | 26.146 2 | 25.486 9 | 30.151 6 | |

| AG | 2.295 2 | 4.352 8 | 3.961 6 | 5.659 6 | |

| QAB/F | 0.382 4 | 0.401 5 | 0.375 2 | 0.542 1 | |

| 第5组 | IE | 6.954 8 | 6.707 8 | 6.575 3 | 7.213 4 |

| SD | 31.492 6 | 27.451 2 | 25.617 1 | 45.142 3 | |

| AG | 4.809 8 | 4.754 3 | 4.017 6 | 5.013 6 | |

| QAB/F | 0.409 6 | 0.391 2 | 0.301 9 | 0.553 8 |

由表 1可以看出, 在第1组图像中本文算法取得的信息熵、标准差、平均梯度、边缘保留因子, 较次优结果分别提高了16.8%、33.4%、16.7%、3.31%;在第2组图像中, 本文算法取得的信息熵、标准差、平均梯度、边缘保留因子, 较次优结果分别提高了7.49%、90.49%、49.99%、4.02%;在第3组图像中, 本文算法取得的信息熵、标准差、平均梯度、边缘保留因子, 较次优结果分别提高了11.52%、91.16%、39.07%、17.47%;在第4组图像中, 本文算法取得的信息熵、标准差、平均梯度、边缘保留因子, 较次优结果分别提高了3.41%、15.31%、30.02%、35.02%;在第5组图像中, 本文算法取得的信息熵、标准差、平均梯度、边缘保留因子, 较次优结果分别提高了3.72%、43.34%、4.24%、35.21%。通过客观评价指标的评测可知, 本文算法在改善噪声的同时, 能够保留红外图像的热目标信息, 以及增强低照度图像的纹理细节信息。

4 结论

针对单独使用红外图像或低照度图像难以对图像中的目标和背景信息进行识别的问题, 提出了基于图像特征的红外图像与低照度图像融合算法。首先, 根据红外图像与低照度图像的特征有针对性地分别进行图像处理, 降低了噪声对红外图像目标信息的影响, 增强了低照度图像的场景细节信息。其次, 利用NSST对红外图像与低照度图像进行分解, 针对高频子带图像特征与低频子带图像特征构建不同的融合规则。最后, 经NSST逆变换获取融合图像。在INO与TNO数据集上的仿真实验表明, 所提算法能够有效综合红外图像的目标信息和低照度图像的场景细节信息, 融合图像清晰自然、对比度适中、符合人眼的视觉感知效果, 可以很好地被应用于军事监控、目标追踪、自动驾驶等领域。

参考文献

基于NSCT和ICA的红外和可见光图像融合方法

[J].

Infrared and visible image fusion method based on NSCT and ICA

[J].

一种基于MDARNet的低照度图像增强方法

[J].DOI:10.13328/j.cnki.jos.006112 [本文引用: 1]

Low-light image enhancement method based on MDARNet

[J].DOI:10.13328/j.cnki.jos.006112 [本文引用: 1]

结合脉冲耦合神经网络与引导滤波的红外与可见光图像融合

[J].

Infrared and visible image fusion combining pulse-coupled neural network and guided filtering

[J].

Fusion of infrared and visible light images based on region segmentation

[J].DOI:10.1016/S1000-9361(08)60071-0 [本文引用: 1]

Medical image fusion using the PCNN based on IQPSO in NSST domain

[J].DOI:10.1049/iet-ipr.2020.0040 [本文引用: 1]

Infrared and visible image fusion based on target-enhanced multiscale transform decomposition

[J].DOI:10.1016/j.ins.2019.08.066 [本文引用: 1]

Multi-focus image fusion using neutrosophic based wavelet transform

[J].DOI:10.1016/j.asoc.2021.107307 [本文引用: 1]

Dual-tree biquaternion wavelet transform and its application to color image fusion

[J].DOI:10.1016/j.sigpro.2020.107513

Image fusion using dual tree discrete wavelet transform and weights optimization

[J].DOI:10.1007/s00371-021-02396-9 [本文引用: 1]

A fast fusion scheme for infrared and visible light images in NSCT domain

[J].DOI:10.1016/j.infrared.2015.07.026 [本文引用: 1]

Multi-focus infrared image fusion based on pulse coupled neural networks in a nonsubsampled contourlet transform domain

[J].

Pansharpening with a gradient domain GIF based on NSST

[J].DOI:10.3390/electronics8020229 [本文引用: 1]

A novel approach for multi-focus image fusion based on SF-PAPCNN and ISML in NSST domain

[J].

A phase congruency-based green fluorescent protein and phase contrast image fusion method in nonsubsampled shearlet transform domain

[J].

Multi-source image fusion algorithm based on fast weighted guided filter

[J].DOI:10.21629/JSEE.2019.05.02 [本文引用: 1]

Contrast enhanced multi sensor image fusion based on guided image filter and NSST

[J].DOI:10.1109/JSEN.2019.2944249 [本文引用: 1]

Multi-modal image fusion via sparse representation and multi-scale anisotropic guided measure

[J].

Denoising of image gradients and total generalized variation denoising

[J].

Sparse directional image representations using the discrete shearlet transform

[J].DOI:10.1016/j.acha.2007.09.003 [本文引用: 1]

Feature linking via synchronization among distributed assemblies: simulation of results from cat cortex

[J].DOI:10.1162/neco.1990.2.3.293 [本文引用: 2]

Medical image fusion with parameter adaptive pulse coupled neural network in nonsubsampled shearlet transform domain

[J].DOI:10.1109/TIM.2018.2838778 [本文引用: 2]

Laplacian re-decomposition for multimodal medical image fusion

[J].DOI:10.1109/TIM.2020.2975405 [本文引用: 1]

IVFuseNet: fusion of infrared and visible light images for depth prediction

[J].

Infrared and visible image fusion method of dual NSCT and PCNN

[J].DOI:10.1371/journal.pone.0239535 [本文引用: 2]

Fusion of infrared and visible images based on adaptive PCNN and information extraction

[J].

Fusing infrared and visible images of different resolutions via total variation model

[J].DOI:10.3390/s18113827 [本文引用: 1]

Infrared and visible image fusion via gradient transfer and total variation minimization

[J].DOI:10.1016/j.inffus.2016.02.001 [本文引用: 1]

A survey of infrared and visual image fusion methods

[J].DOI:10.1016/j.infrared.2017.07.010 [本文引用: 1]

Fusion method for infrared and visible images based on improved quantum theory model

[J].